Automatic Prompt Engineer (APE)

Bildquelle: Zhou et al., (2022) (opens in a new tab)

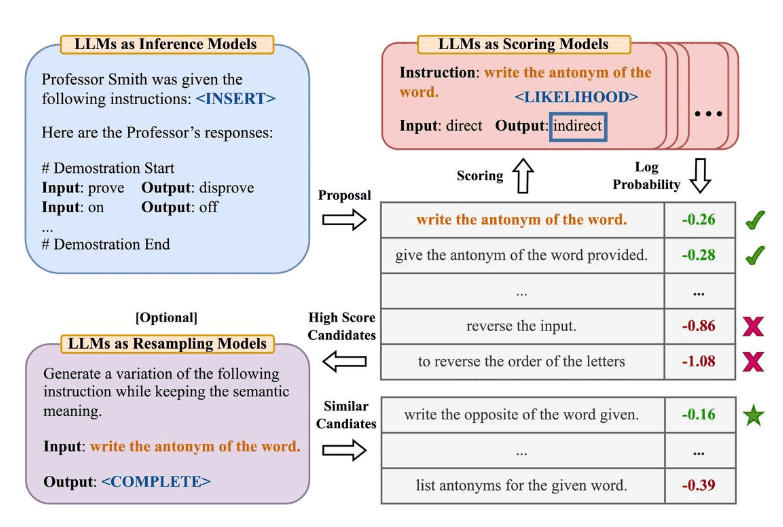

Zhou et al., (2022) (opens in a new tab) schlagen den Automatischen Prompt Ingenieur (Automatic Prompt Engineer, kurz APE) vor, ein Framework für die automatische Erstellung und Auswahl von Instruktionen. Das Problem der Instruktionsgenerierung wird als Synthese natürlicher Sprache konzipiert, adressiert als ein Black-Box-Optimierungsproblem, unter Verwendung von LLMs, um Kandidatenlösungen zu generieren und zu suchen.

Der erste Schritt beinhaltet ein großes Sprachmodell (als Inferenzmodell), das Ausführungsdemonstrationen erhält, um Instruktionskandidaten für eine Aufgabe zu generieren. Diese Kandidatenlösungen leiten das Suchverfahren an. Die Instruktionen werden mit einem Zielmodell ausgeführt, und dann wird die geeignetste Instruktion basierend auf berechneten Evaluierungswerten ausgewählt.

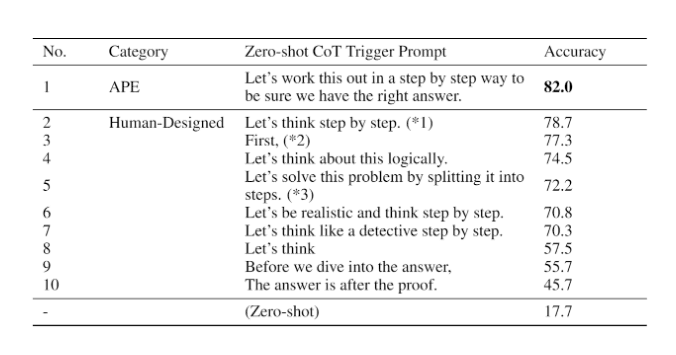

APE entdeckt einen besseren Zero-Shot CoT-Prompt als den von Menschen entwickelten Prompt "Lass uns Schritt für Schritt denken" (Kojima et al., 2022 (opens in a new tab)).

Der Prompt "Lassen Sie uns dies Schritt für Schritt durcharbeiten, um sicherzugehen, dass wir die richtige Antwort haben." ruft Ketten-des-Denkens-Argumentation hervor und verbessert die Leistung bei den MultiArith- und GSM8K-Benchmarks:

Bildquelle: Zhou et al., (2022) (opens in a new tab)

Dieses Paper berührt ein wichtiges Thema im Zusammenhang mit dem Prompt Engineering: die Idee, Prompts automatisch zu optimieren. Obwohl wir nicht tief in dieses Thema in diesem Leitfaden eingehen, hier sind einige Schlüsselpapiere, wenn Sie am Thema interessiert sind:

- Prompt-OIRL (opens in a new tab) - schlägt vor, Offline-Inverse-Verstärkungslernen zu verwenden, um von der Anfrage abhängige Prompts zu erstellen.

- OPRO (opens in a new tab) - führt die Idee ein, LLMs zu verwenden, um Prompts zu optimieren: Lassen Sie LLMs "Tief durchatmen", verbessert die Leistung bei Mathematikproblemen.

- AutoPrompt (opens in a new tab) - schlägt einen Ansatz vor, um automatisch Prompts für eine vielfältige Aufgabenpalette basierend auf einer durch Gradienten geleiteten Suche zu erstellen.

- Prefix Tuning (opens in a new tab) - eine leichtgewichtige Alternative zum Feinabstimmen, die einen trainierbaren kontinuierlichen Prefix für NLG-Aufgaben voranstellt.

- Prompt Tuning (opens in a new tab) - schlägt einen Mechanismus für das Lernen von Soft-Prompts durch Rückpropagierung vor.