LLM Reasoning

In den letzten Jahren haben große Sprachmodelle (LLMs) signifikante Fortschritte in einer breiten Palette von Aufgaben gemacht. In jüngster Zeit haben LLMs das Potenzial gezeigt, Logikfähigkeiten (Reasoning) zu demonstrieren, wenn sie auf eine ausreichend große Größe skaliert werden. Verschiedene Arten der Logik sind grundlegend für Intelligenz, aber es ist noch nicht vollständig verstanden, wie KI-Modelle diese Fähigkeit erlernen und nutzen können, um komplexe Probleme zu lösen. Es ist ein Bereich von enormem Fokus und Investition für viele Forschungslabore.

Reasoning mit Foundation Models

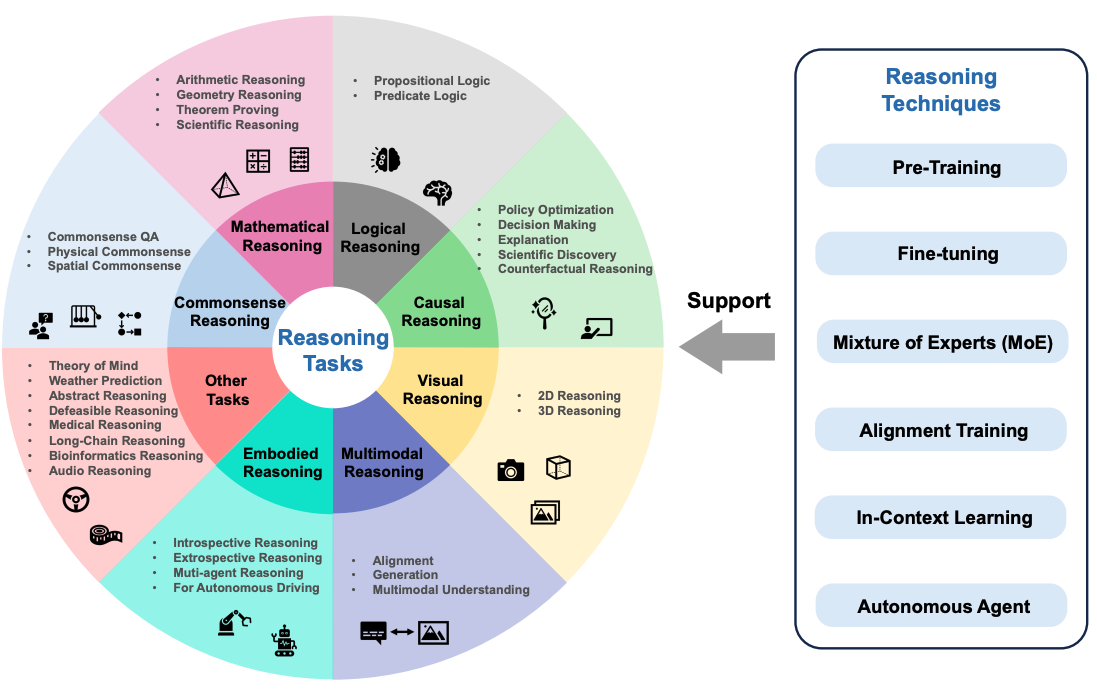

Sun et al. (2023) (opens in a new tab) haben kürzlich einen Überblick über Reasoning mit Foundation Models vorgeschlagen, der sich auf die neuesten Entwicklungen in verschiedenen Logikaufgaben konzentriert. Diese Arbeit fokussiert sich auch auf einen umfassenderen Blick auf Reasoning, der multimodale Modelle und autonome Sprachagenten umspannt.

Logikaufgaben könnten Aufgaben wie mathematische Logik, logisches Schlussfolgern, kausales Schlussfolgern, visuelles Schlussfolgern und mehr beinhalten. Die folgende Abbildung zeigt einen Überblick über die in dem Survey-Paper diskutierten Logikaufgaben, einschließlich Reasoning-Techniken für Foundation Models wie Ausrichtungstraining und In-Context-Lernen.

Abbildungsquelle: Sun et al., 2023 (opens in a new tab)

Abbildungsquelle: Sun et al., 2023 (opens in a new tab)

Wie kann Reasoning in LLMs hervorgerufen werden?

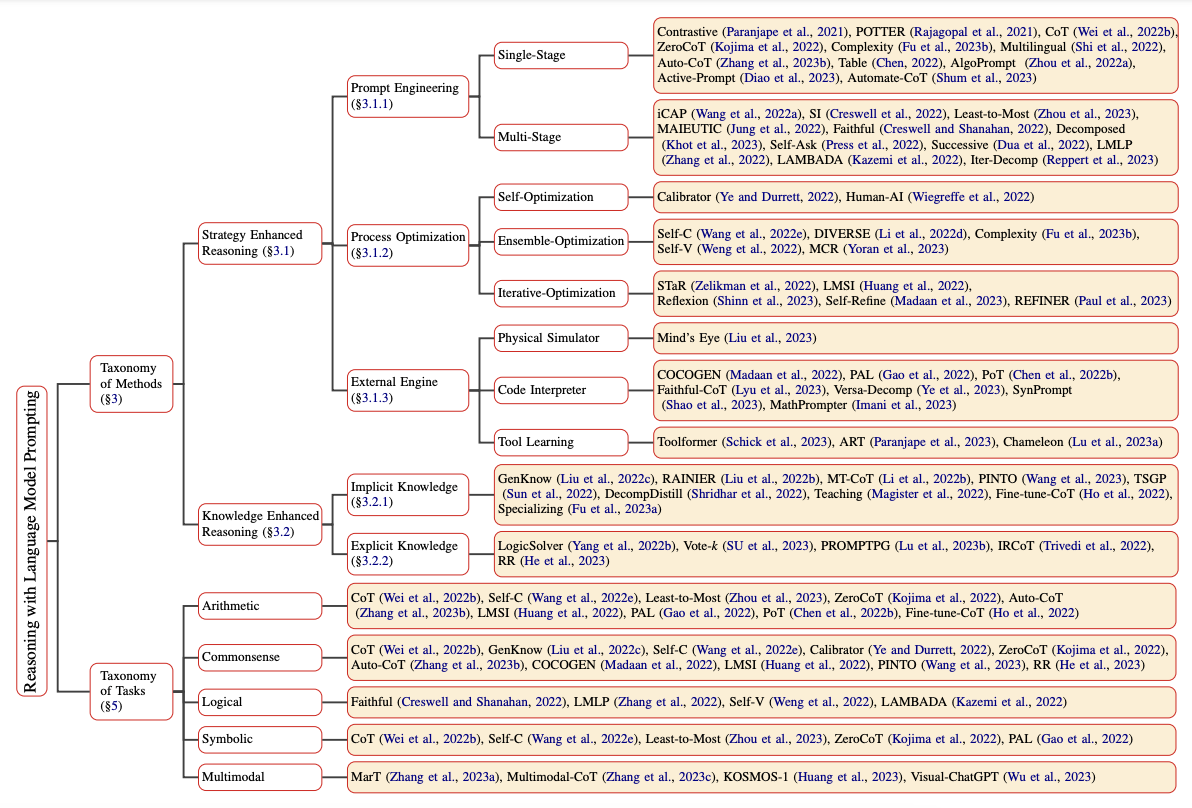

Reasoning in LLMs kann mit vielen verschiedenen Prompting-Ansätzen hervorgerufen und verbessert werden. Qiao et al. (2023) (opens in a new tab) haben die Forschung zu Logikmethoden in zwei verschiedene Zweige kategorisiert, nämlich Reasoning-Verstärkungsstrategie und Wissensverstärkungs-Reasoning. Reasoning-Strategien beinhalten Prompt-Engineering, Prozessoptimierung und externe Motoren. Single-Stage Prompting-Strategien beinhalten zum Beispiel Chain-of-Thought (opens in a new tab) und Active-Prompt (opens in a new tab). Eine vollständige Taxonomie des Reasonings mit Sprachmodell-Prompting kann in dem Paper gefunden und in der Abbildung unten zusammengefasst werden:

Abbildungsquelle: Qiao et al., 2023 (opens in a new tab)

Abbildungsquelle: Qiao et al., 2023 (opens in a new tab)

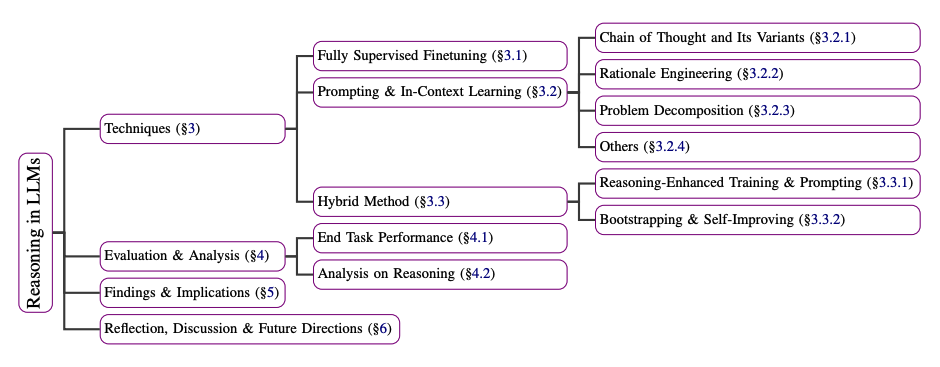

Huang et al. (2023) erläutern auch eine Zusammenfassung von Techniken zur Verbesserung oder Hervorrufung von Reasoning in LLMs wie GPT-3. Diese Techniken reichen von vollständig supervidierten Feinabstimmungsmodellen, die auf Erklärungsdatensätzen trainiert wurden, bis hin zu Prompting-Methoden wie Chain-of-Thought, Problemdesintegration und In-Context-Lernen. Unten ist eine Zusammenfassung der Techniken beschrieben, die in dem Paper beschrieben sind:

Abbildungsquelle: Huang et al., 2023 (opens in a new tab)

Abbildungsquelle: Huang et al., 2023 (opens in a new tab)

Können LLMs Reasoning anwenden und planen?

Es gibt viel Debatte darüber, ob LLMs Reasoning anwenden und planen können. Sowohl Reasoning als auch Planung sind wichtige Fähigkeiten für die Erschließung komplexer Anwendungen mit LLMs, wie zum Beispiel in den Bereichen Robotik und autonome Agenten. Ein Positionspapier von Subbarao Kambhampati (2024) (opens in a new tab) diskutiert das Thema Reasoning und Planung für LLMs.

Hier ist eine Zusammenfassung der Schlussfolgerung des Autors:

Um zusammenzufassen, nichts, was ich gelesen, verifiziert oder gemacht habe, gibt mir einen überzeugenden Grund zu glauben, dass LLMs Reasoning/Planung anwenden, wie normalerweise verstanden. Was sie stattdessen tun, bewaffnet mit web-scale Training, ist eine Form der universellen annähernden Abfrage, die, wie ich argumentiert habe, manchmal für Reasoning-Fähigkeiten gehalten werden kann.

Referenzen

- Reasoning with Language Model Prompting: A Survey (opens in a new tab)

- Towards Reasoning in Large Language Models: A Survey (opens in a new tab)

- Can Large Language Models Reason and Plan? (opens in a new tab)

- Rethinking the Bounds of LLM Reasoning: Are Multi-Agent Discussions the Key? (opens in a new tab)

- Awesome LLM Reasoning (opens in a new tab)