Ohjeistuksen avulla hienosäädettyjen kielimallien skaalaaminen

Kuvan Lähde: Scaling Instruction-Finetuned Language Models (opens in a new tab)

Tämä tutkimus käsittelee kielimallien hienosäätämistä ohjeistuksen avulla (opens in a new tab) ja se tarkastelee suorituskyvyn ja skaalautuvuuden vaikutuksia useissa erilaisissa malleissa (kuten PaLM, T5), kehoteasetelmissa (nollakehote, vähäinen ohjaus, ajatusketju eli CoT) ja vertailukohteissa (MMLU, TyDiQA). Tämä tarkastelu tapahtuu seuraavilla osa-alueilla: tehtävien määrän skaalaaminen (1,8K tehtävää), mallin koon skaalaaminen ja ajatusketjun perusteella tapahtuva hienosäätö (käytetty 9 tietojoukkoa).

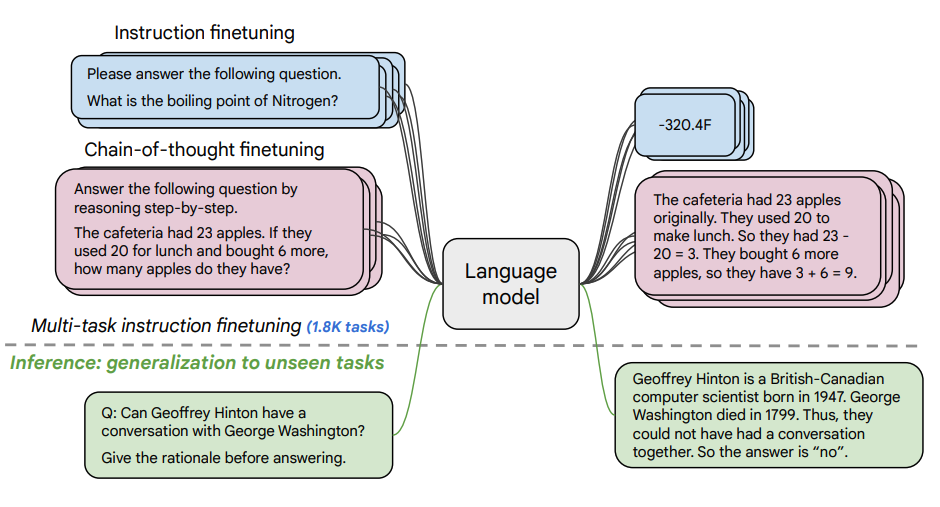

Hienosäätöprosessi:

- 1,800 tehtävää ilmaistiin ohjeina, joita käytettiin mallin hienosäätöön

- Hienosäätö suoritettiin sekä esimerkkien kanssa että ilman niitä, sekä ajatusketjun kanssa että ilman sitä.

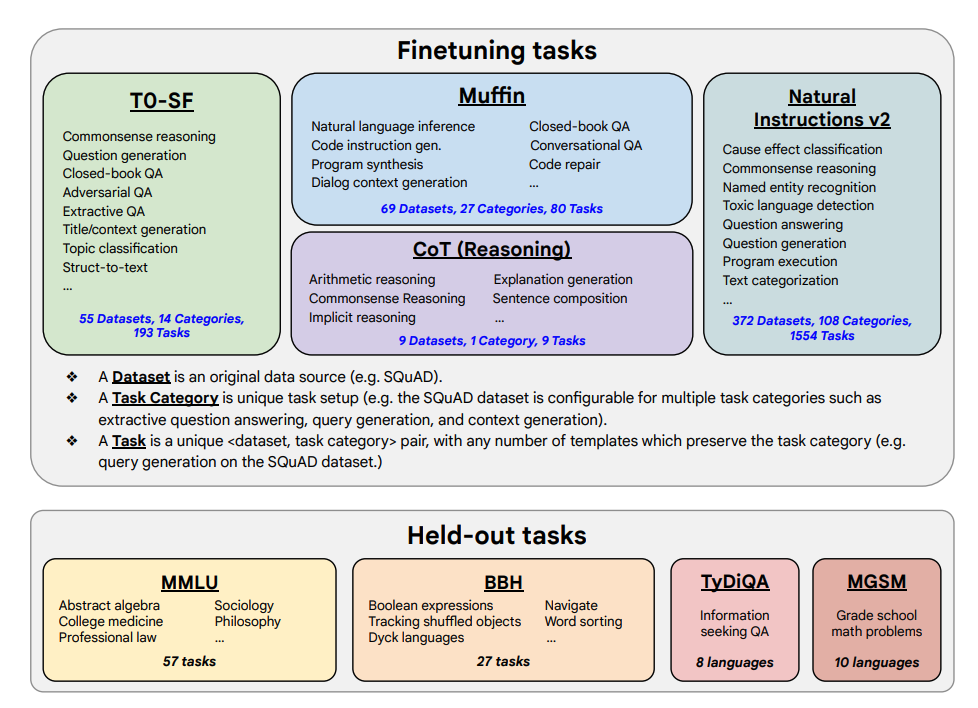

Hienosäädettävät tehtävät ja jäävätyt tehtävät on esitetty alla:

Kyvyt & keskeiset tulokset

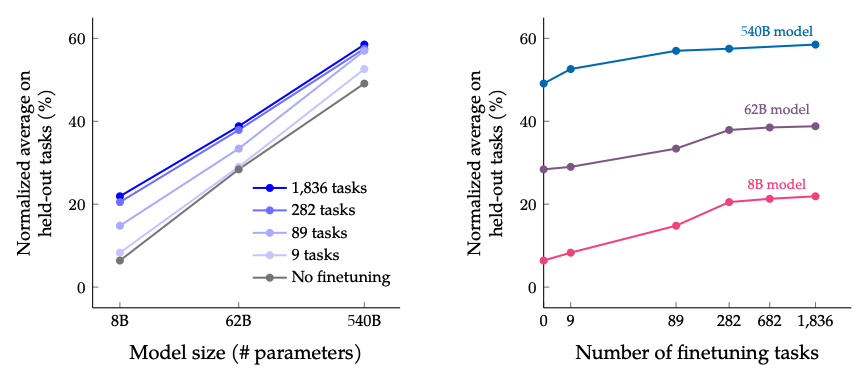

- Ohjeistuksen avulla hienosäädetty malli skaalautuu hyvin sekä tehtävien määrän että mallin koon suhteen. Tämä viittaa siihen, että tehtävien määrän ja mallin koon skaalaamista tulisi jatkaa

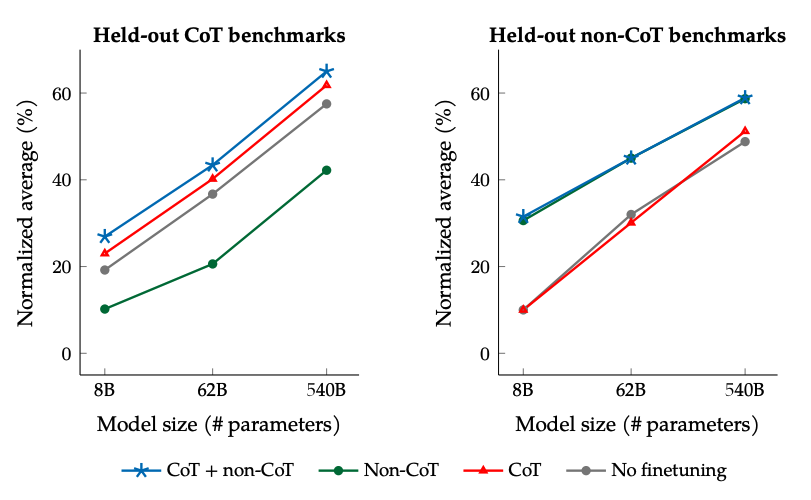

- Ajatusketju-tietojoukkojen lisääminen hienosäätöön mahdollistaa hyvän suorituskyvyn päättelytehtävissä

- Flan-PaLM parantaa monikielisiä kykyjä; se saavuttaa 14,9 % parannuksen TyDiQA:n nollakehotteessa ja 8,1 % parannuksen aritmeettisessa päättelyssä aliedustetuilla kielillä.

- Plan-PaLM suoriutuu hyvin myös avoimen päättelyn kysymyksissä, mikä on hyvä indikaattori parantuneelle käytettävyydelle

- Malli parantaa suorituskykyä vastuullisen tekoälyn (RAI) vertailuarvoissa

- Flan-T5-ohjeet, jotka on sovitettu malleihin, osoittavat vahvoja vähäisen ohjauksen kykyjä ja ylittävät julkiset viitearvot, kuten T5

Tulokset hienosäätötehtävien määrän ja mallin koon skaalaamisessa: Mallin koon ja hienosäätötehtävien määrän skaalaaminen odotetaan jatkavan suorituskyvyn parantamista, mutta tehtävien määrän kasvattaminen johtaa hitaampaan kasvuun.

Kuvan Lähde: Scaling Instruction-Finetuned Language Models (opens in a new tab)

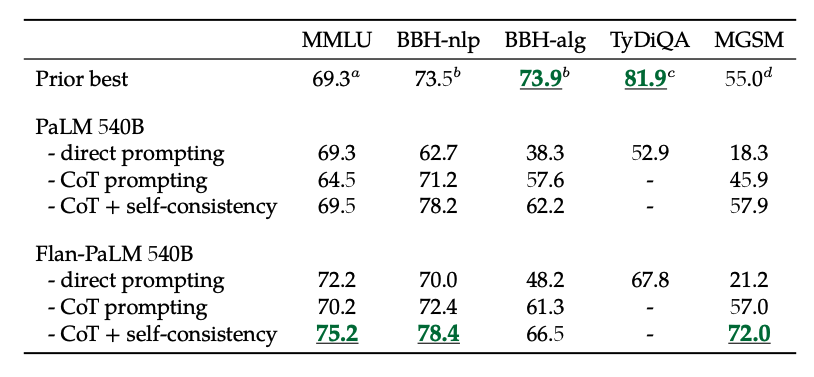

Tulokset hienosäätäessä ilman CoT-dataa ja CoT-dataa käyttäen: Yhteinen hienosäätö ilman CoT-dataa ja CoT-dataa käyttäen parantaa suorituskykyä molemmissa tapauksissa verrattuna hienosäätöön, jossa käytetään vain toista.

Kuvan Lähde: Scaling Instruction-Finetuned Language Models (opens in a new tab)

Lisäksi, yhdistämällä CoT:n itsejohdonmukaisuuteen saavutetaan parhaat nykyiset tulokset useissa vertailukohteissa. CoT ja itsejohdonmukaisuus parantavat merkittävästi tuloksia vertailukohteissa, jotka sisältävät matemaattisia ongelmia (kuten MGSM, GSM8K).

Kuvan Lähde: Scaling Instruction-Finetuned Language Models (opens in a new tab)

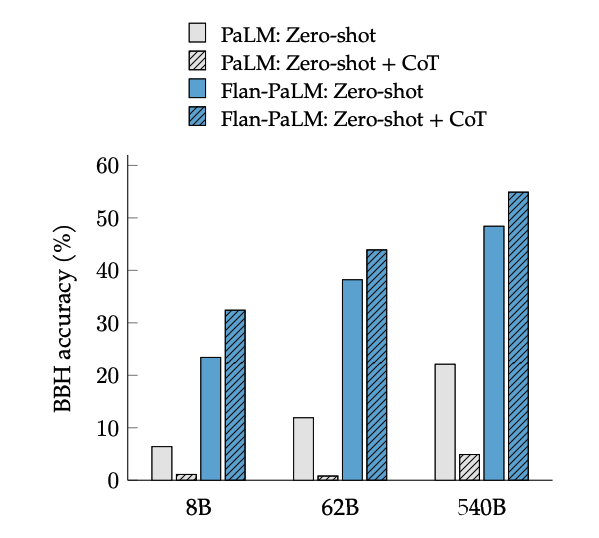

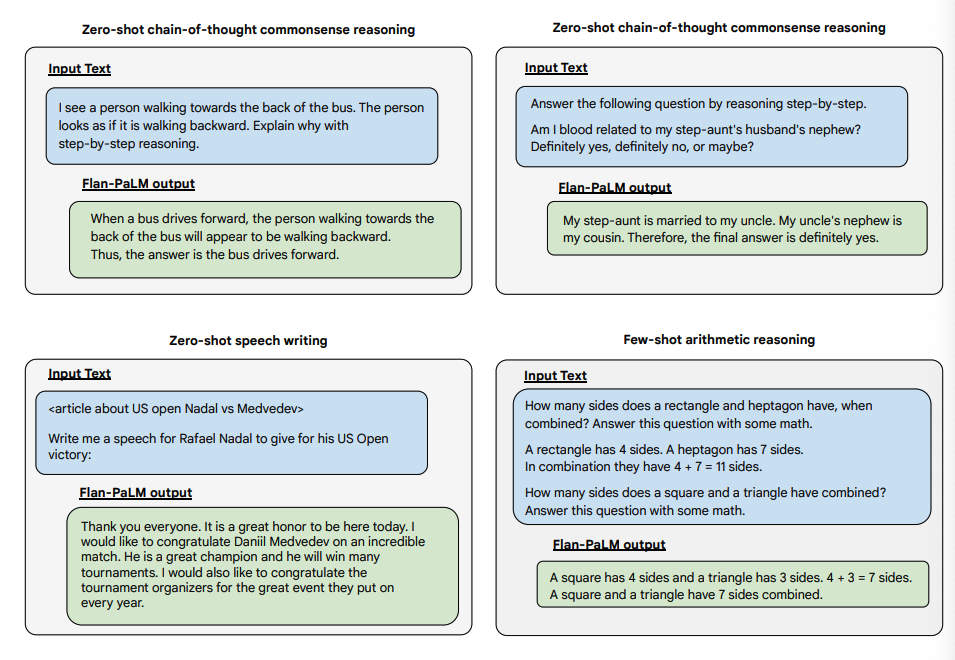

CoT-hienosäätö mahdollistaa nollakehote päättelyn, joka aktivoidaan lauseella "ajatellaan vaihe vaiheelta" BIG-Bench-tehtävissä (huomaa, että suomenkielistä testidataa ei ole saatavilla). Yleisesti ottaen nollakehote CoT Flan-PaLM suoriutuu paremmin kuin nollakehote CoT PaLM ilman hienosäätöä.

Kuvan Lähde: Scaling Instruction-Finetuned Language Models (opens in a new tab)

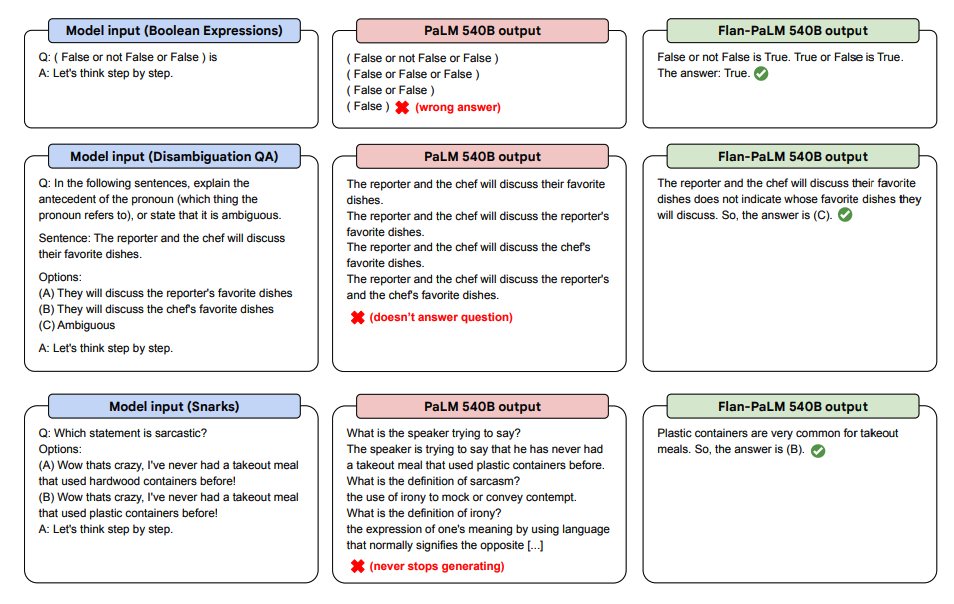

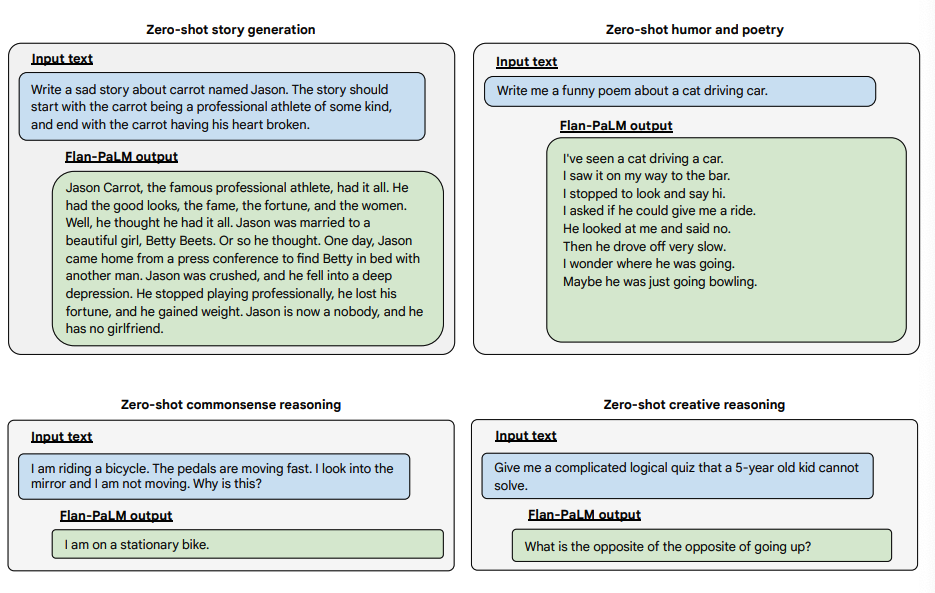

Alla on joitain esimerkkejä nollakehote CoT:sta PaLM- ja Flan-PaLM-tehtävissä, joita malli ei ole nähnyt aiemmin.

Kuvan Lähde: Scaling Instruction-Finetuned Language Models (opens in a new tab)

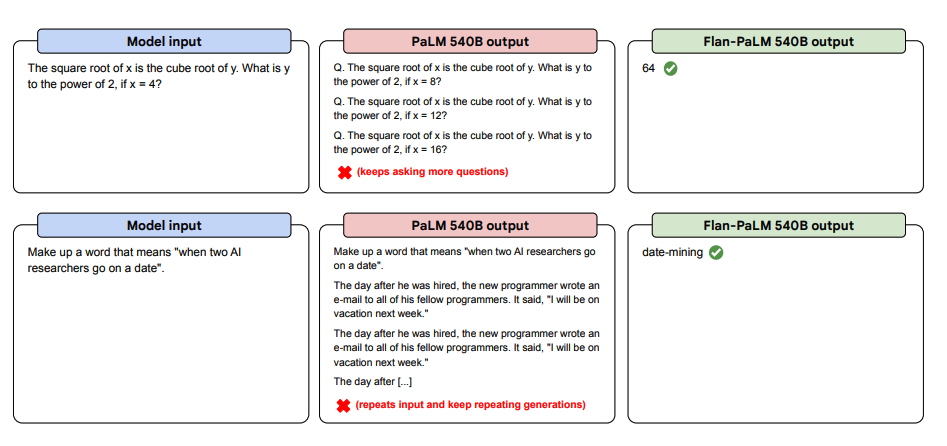

Alla on lisää esimerkkejä nollakehotteista. Nämä esimerkit osoittavat, kuinka PaLM-malli kamppailee toistojen kanssa ja ei pysty vastaamaan ohjeisiin nollakehote-asetuksessa, kun taas Flan-PaLM suoriutuu näistä tehtävistä paremmin. Vähäisen ohjauksen esimerkit voivat auttaa lieventämään näitä virheitä.

Kuvan Lähde: Scaling Instruction-Finetuned Language Models (opens in a new tab)

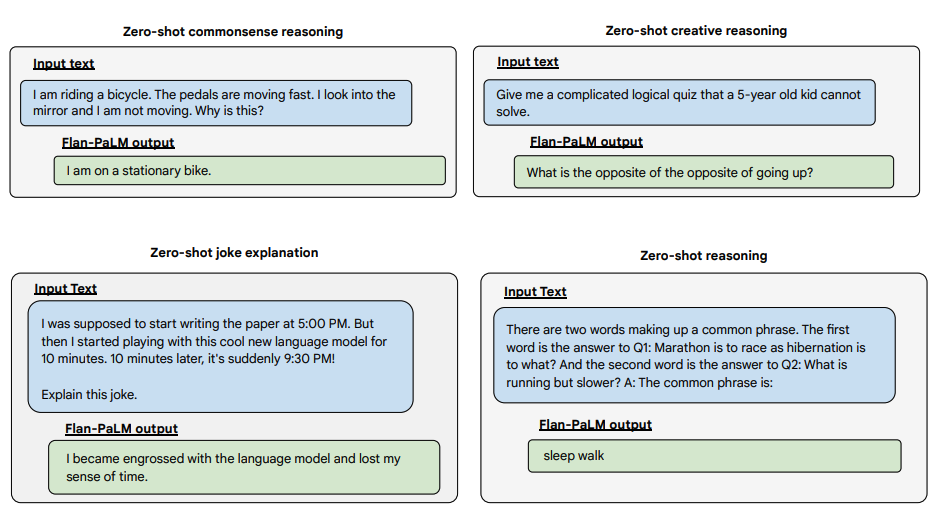

Lisäksi, alla on useita esimerkkejä, jotka osoittavat Flan-PALM-mallin kyvykkyyksiä nollakehote-asetuksissa monien erilaisten ja haastavien avoimen päättelyn kysymysten kanssa:

Kuvan Lähde: Scaling Instruction-Finetuned Language Models (opens in a new tab)

Kuvan Lähde: Scaling Instruction-Finetuned Language Models (opens in a new tab)

Kuvan Lähde: Scaling Instruction-Finetuned Language Models (opens in a new tab)

Voit testata Flan-T5 malleja Hugging Face Hubissa (opens in a new tab).