Échelle de modèles de langage finement ajustés aux instructions

Quoi de neuf ?

Image Source: Scaling Instruction-Finetuned Language Models (opens in a new tab)

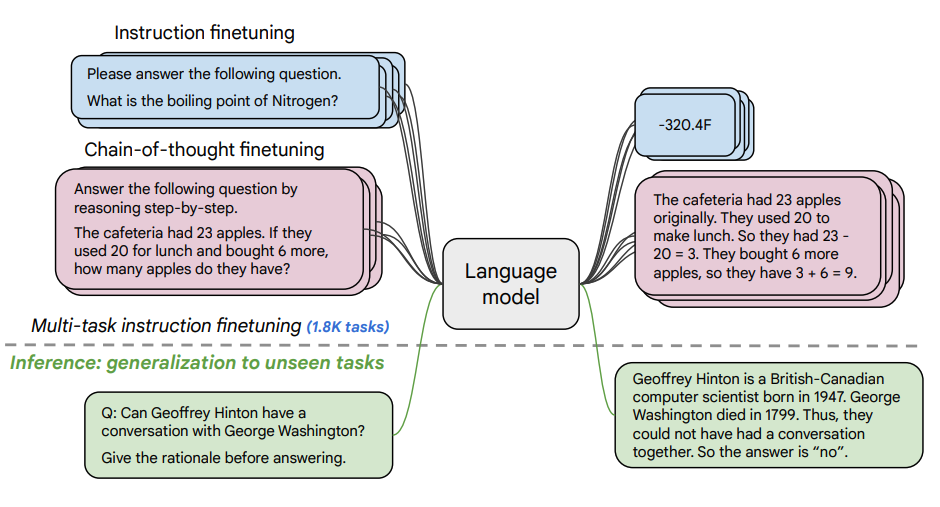

This paper explores the benefits scaling instruction finetuning (opens in a new tab) and how it improves performance on a variety of models (PaLM, T5), prompting setups (zero-shot, few-shot, CoT), and benchmarks (MMLU, TyDiQA). This is explored with the following aspects: scaling the number of tasks (1.8K tasks), scaling model size, and finetuning on chain-of-thought data (9 datasets used).

Procédure de finetuning

- 1.8K tasks were phrased as instructions and used to finetune the model

- Uses both with and without exemplars, and with and without CoT

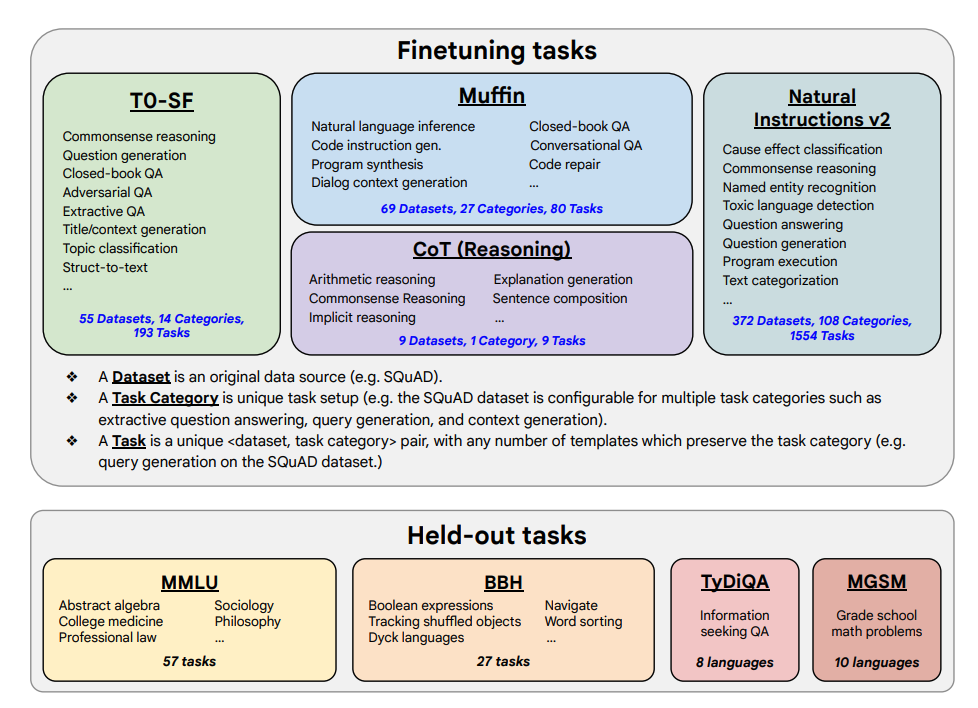

Finetuning tasks and held out tasks shown below:

Capacités et résultats clés

- L'optimisation de l'instruction s'étend bien avec le nombre de tâches et la taille du modèle ; cela suggère la nécessité de faire évoluer le nombre de tâches et la taille du modèle encore plus loin.

- L'ajout de jeux de données CoT dans l'optimisation des instructions permet une bonne performance sur les tâches de raisonnement.

- Flan-PaLM a amélioré les capacités multilingues ; 14,9 % d'amélioration sur TyDiQA en une seule étape ; 8,1 % d'amélioration sur le raisonnement arithmétique dans les langues sous-représentées.

- Plan-PaLM fonctionne également bien sur les questions de génération ouverte, ce qui est un bon indicateur d'une meilleure utilisabilité.

- Améliore les performances sur les benchmarks d'Intelligence Artificielle Responsable (IAR).

- Les modèles optimisés par instruction de Flan-T5 démontrent de solides capacités en quelques étapes et surpassent les checkpoints publics tels que T5.

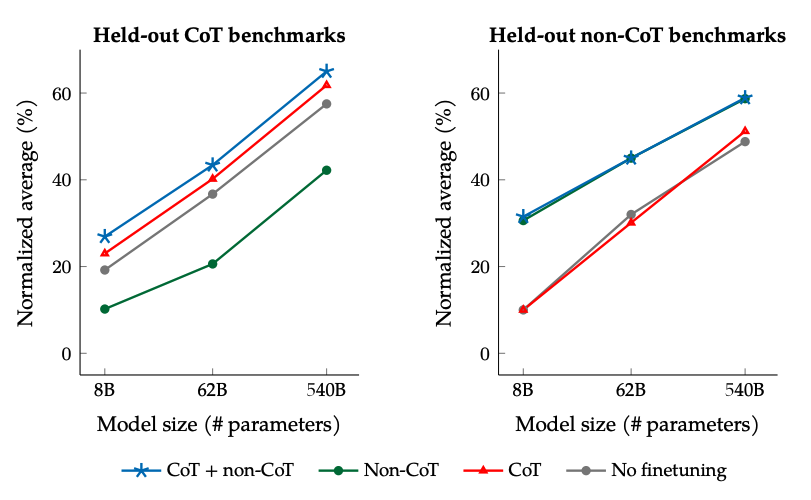

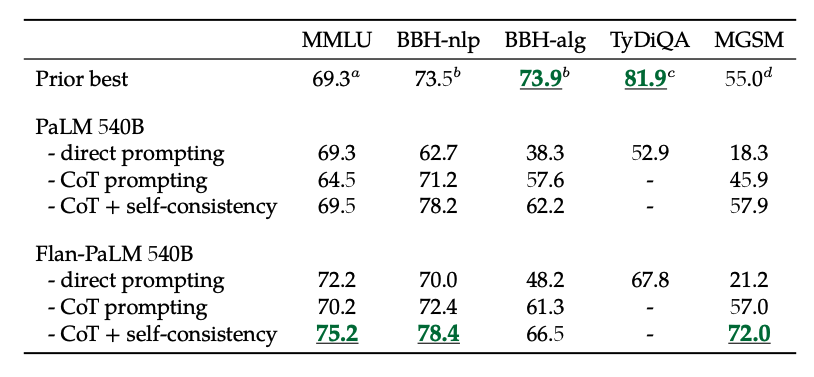

Les résultats lors de la mise à l'échelle du nombre de tâches de réglage fin et de la taille du modèle : la mise à l'échelle de la taille du modèle et du nombre de tâches de réglage fin devrait continuer à améliorer les performances, bien que la mise à l'échelle du nombre de tâches ait des rendements réduits.

Image Source: Scaling Instruction-Finetuned Language Models (opens in a new tab)

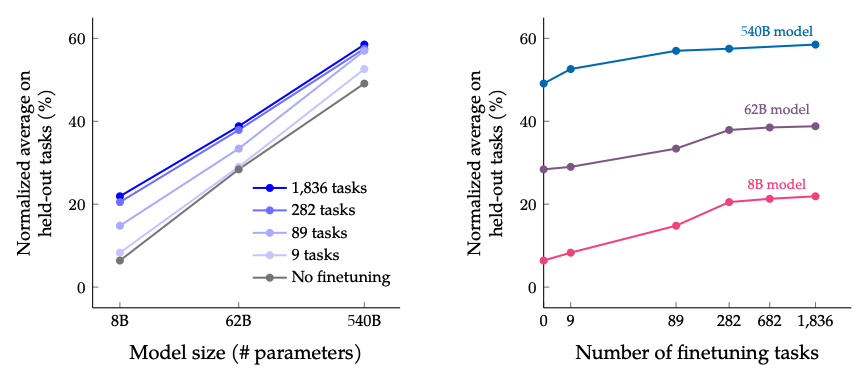

Résultats lors d'un réglage fin avec des données non-CoT et CoT : Un réglage fin conjoint sur des données non-CoT et CoT améliore les performances des deux évaluations, par rapport à un réglage fin sur l'une ou l'autre.

Image Source: Scaling Instruction-Finetuned Language Models (opens in a new tab)

De plus, l'auto-cohérence combinée au CoT permet d'obtenir des résultats SoTA sur plusieurs benchmarks. CoT + auto-cohérence améliore également considérablement les résultats sur les benchmarks impliquant des problèmes mathématiques (par exemple, MGSM, GSM8K).

Image Source: Scaling Instruction-Finetuned Language Models (opens in a new tab)

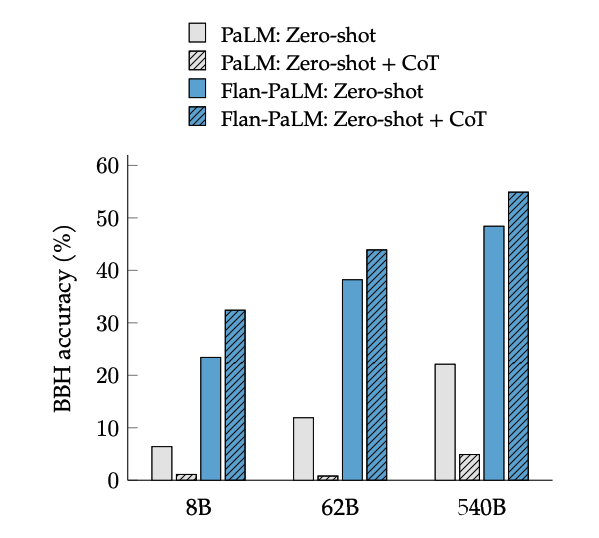

Le réglage fin du CoT déverrouille le raisonnement zéro coup, activé par la phrase "pensons étape par étape", sur les tâches BIG-Bench. En général, le CoT Flan-PaLM à tir zéro surpasse le CoT PaLM à tir zéro sans réglage fin.

Image Source: Scaling Instruction-Finetuned Language Models (opens in a new tab)

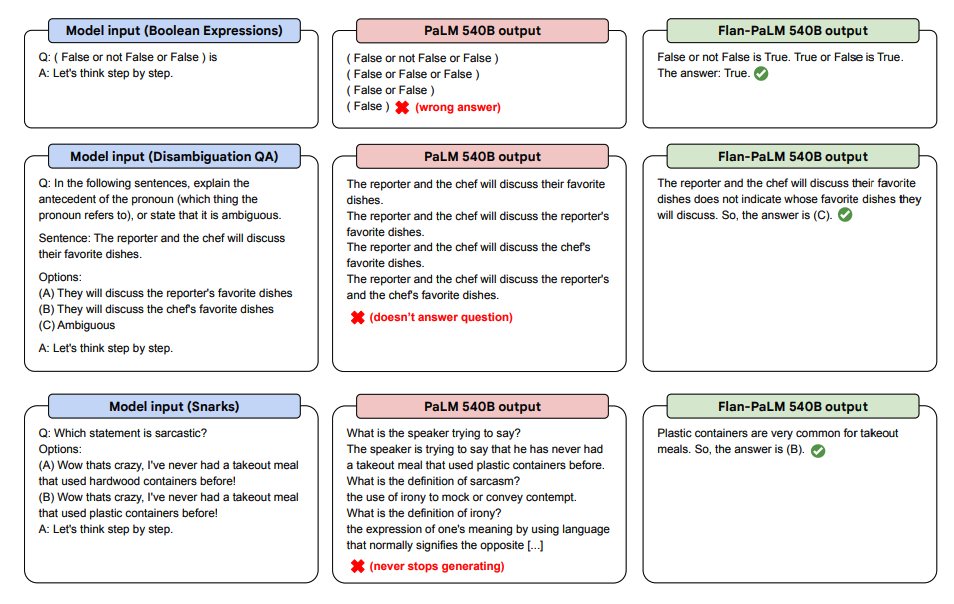

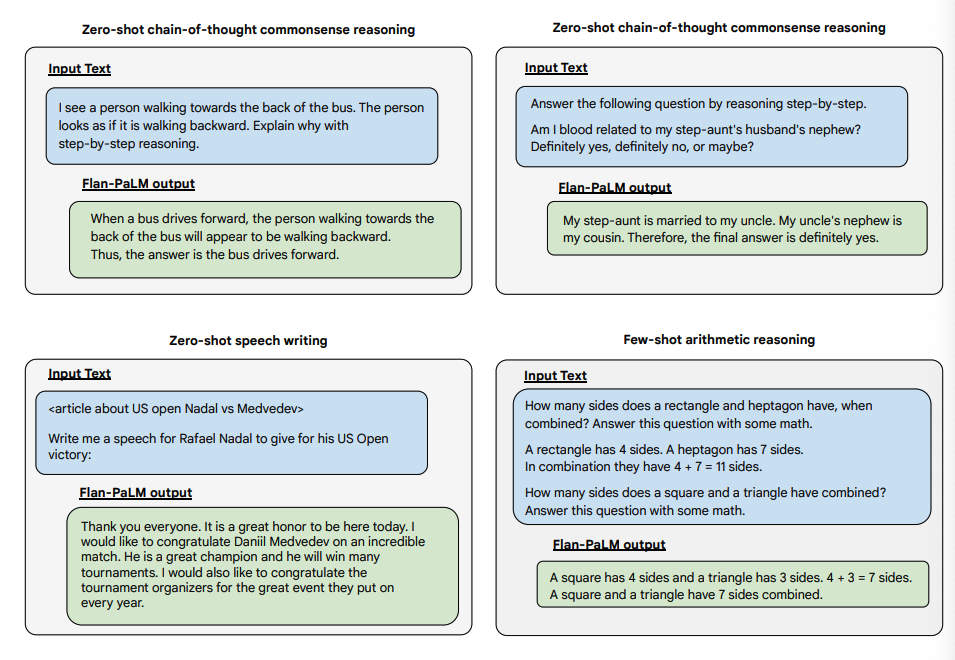

Vous trouverez ci-dessous quelques démonstrations de CoT à tir zéro pour PaLM et Flan-PaLM dans des tâches invisibles.

Image Source: Scaling Instruction-Finetuned Language Models (opens in a new tab)

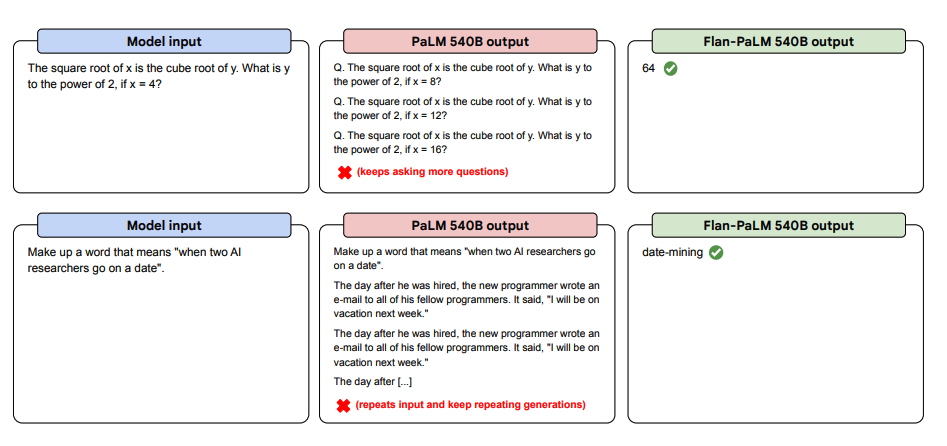

Ci-dessous se trouvent d'autres exemples pour la génération de texte sans cible. Cela montre comment le modèle PaLM a du mal avec les répétitions et ne répond pas aux instructions dans le contexte de génération de texte sans cible, tandis que le modèle Flan-PaLM est capable de bien performer. Les exemples exemplaires en quelques tirs peuvent atténuer ces erreurs.

Image Source: Scaling Instruction-Finetuned Language Models (opens in a new tab)

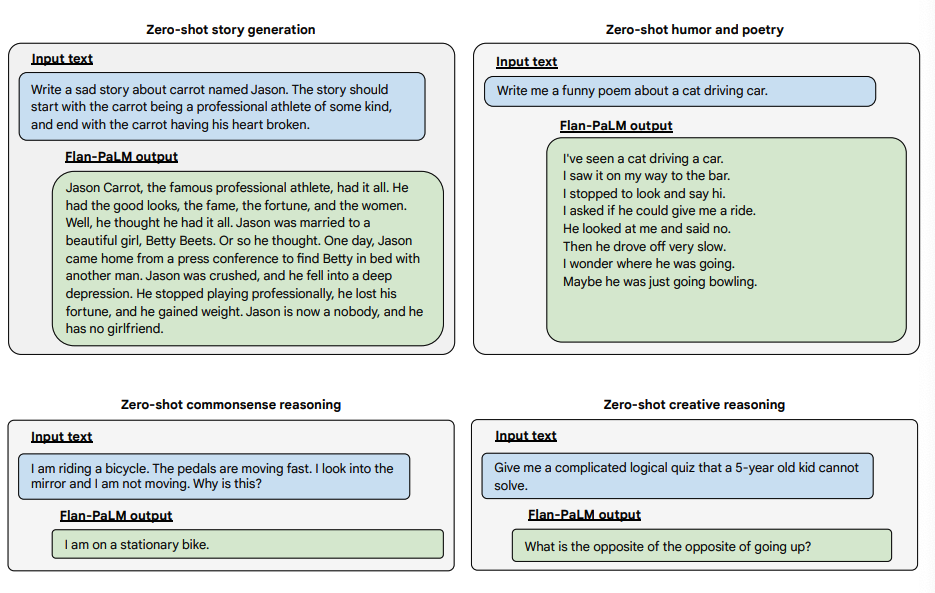

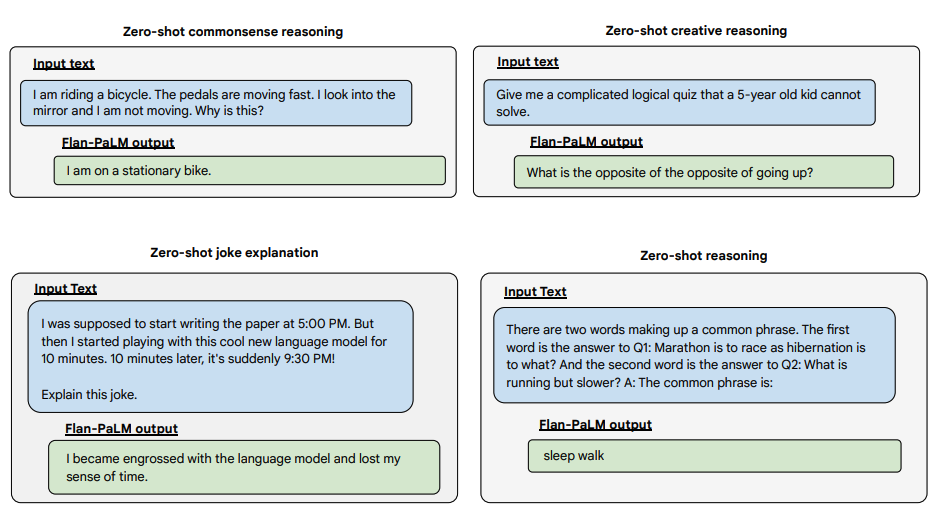

Vous trouverez ci-dessous quelques exemples démontrant davantage de capacités de tir zéro du modèle Flan-PALM sur plusieurs types de questions ouvertes difficiles :

Image Source: Scaling Instruction-Finetuned Language Models (opens in a new tab)

Image Source: Scaling Instruction-Finetuned Language Models (opens in a new tab)

Image Source: Scaling Instruction-Finetuned Language Models (opens in a new tab)

You can try Flan-T5 models on the Hugging Face Hub (opens in a new tab).